所有的文章会迁移到微信公众号,如果对我的文章和分享感兴趣的可以关注一下我的公众号,后续的文章会同步在公众号中分享和发表。

再次感谢大家的关注,谢谢!

所有的文章会迁移到微信公众号,如果对我的文章和分享感兴趣的可以关注一下我的公众号,后续的文章会同步在公众号中分享和发表。

再次感谢大家的关注,谢谢!

ORM = Object Relational Mapping(对象关系映射)。它是一种 让你用面向对象的方式操作数据库 的技术。

一句话解释:

ORM = 把 Python(或其他语言)里的对象 ↔ 数据库里的表记录 互相转换的工具。

举个最直观的例子:

不用 ORM(纯 SQL)1

2

3cursor.execute("SELECT id, name, age FROM users WHERE id = 1")

row = cursor.fetchone()

user = {"id": row[0], "name": row[1], "age": row[2]}

使用 ORM(以 SQLAlchemy 为例)1

user = session.query(User).filter_by(id=1).first()

数据库里的users表,就像程序里的一个User类;每个数据行就是类的实例。

也就是说:

数据库表 → 类(Class)

数据行 → 对象(Object)

表字段 → 类属性(Attribute)

由于后续的课程中会使用到大模型去做相关的实验,所以需要提前准备一个大模型API,用于后续调用。

可以直接使用Ollama,也可以使用其他厂商的API【例如:deepseek,qwen,豆包等等】。

或者参考我的博客教程

1 | from utils.llms import OllamaChat |

1 | chat_model = OllamaChat( |

1 | responses = chat_model.chat("你好,你是谁?", stream=True) |

<think>

</think>

你好!我是Qwen,是阿里巴巴集团旗下的通义实验室自主研发的超大规模语言模型。我能够进行多轮对话、回答问题、创作文字,比如写故事、写邮件、写剧本等,还能进行逻辑推理、多语言翻译、代码生成等任务。我的目标是让每个人都能更轻松地获取信息、表达想法和创造内容。有什么我可以帮助你的吗?

当前大语言模型(LLMs)如 ChatGPT、DeepSeek、Qwen、Claude 等迅速发展,在自然语言处理、知识问答、代码生成、办公助手等方面展现出强大能力。然而,很多企业、高校和组织在应用这些模型时,会面临以下问题:

因此,大模型私有化部署应运而生:将开源模型部署在本地服务器、GPU 算力平台、云原生平台或边缘设备中,构建独立的智能服务系统。

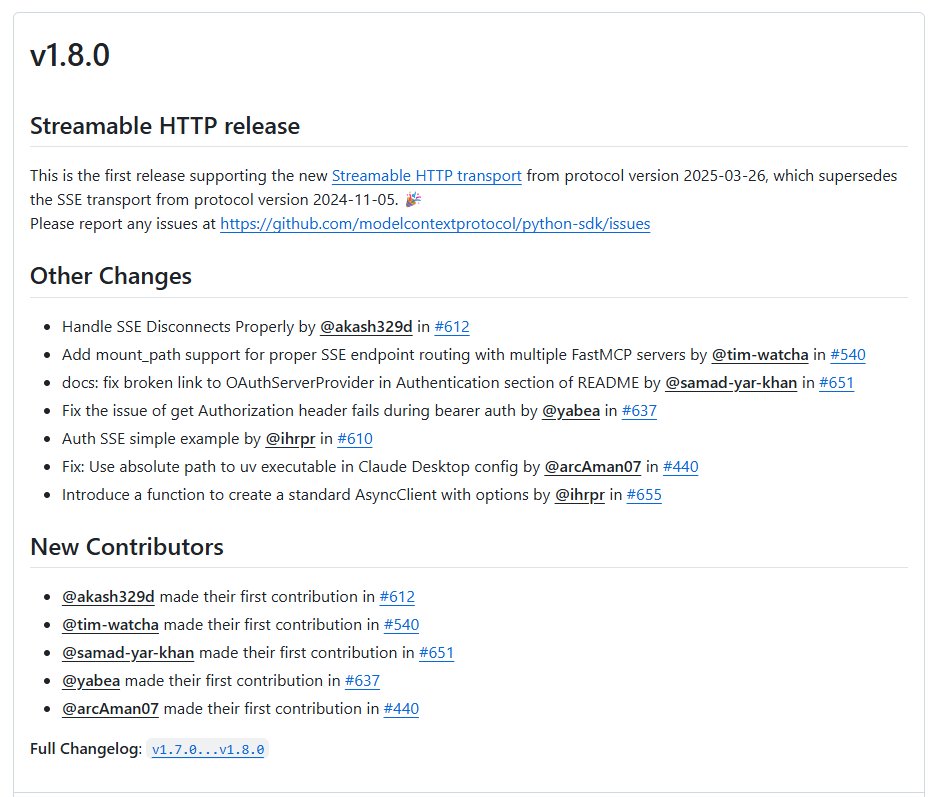

随着人工智能(AI)技术的迅猛发展,AI助手与应用程序之间的高效通信变得尤为重要。模型上下文协议(Model Context Protocol,简称MCP)应运而生,旨在为大型语言模型(LLMs)与外部数据源和工具之间提供标准化的接口。在MCP的众多特性中,Streamable HTTP传输机制作为一种现代化的通信方式,正在逐渐取代传统的Server-Sent Events(SSE)传输方式,成为AI通信的新标准。