需求:完成一个Seq2Seq模型,实现往模型中输入一串数字,输出这串数字+0

例如:

- 输入:15925858456,输出:159258584560

1 | import torch |

需求:完成一个Seq2Seq模型,实现往模型中输入一串数字,输出这串数字+0

例如:

1 | import torch |

文本向量化是将文本数据转化为数值向量的过程,它在自然语言处理(NLP)和机器学习任务中非常重要,有以下几个关键原因:

AutoDL是一个GPU租用平台,它提供了各种型号的服务器供用户选择,使得用户可以在云端进行深度学习模型的训练和推理。这个平台的特点包括网络无要求、部署简单、稳定,且价格合理。无论是使用Mac电脑还是低配置的Windows电脑,用户都可以完全通过云端部署,自己租用服务器,并通过浏览器打开进行使用。AutoDL支持多种服务器配置,用户可以根据自己的需求租用相应配置的服务器,从而满足不同的计算需求。

Ollama是一个功能强大的开源框架,旨在简化在Docker容器中部署和管理大型语言模型(LLM)的过程。本文将介绍Ollama的特点、优势以及如何在本地使用Ollama高效运行大型语言模型,为非专业读者提供清晰易懂的技术指南。

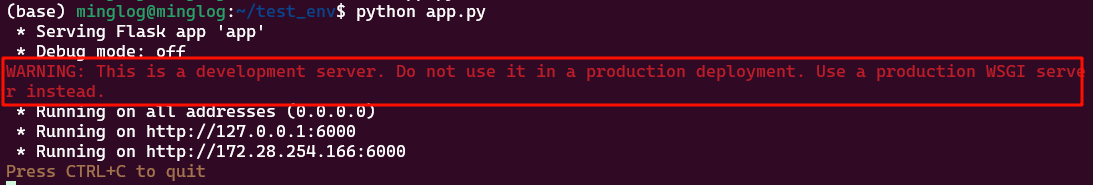

Flask自带的web服务器可用于开发环境运行调试,不适合部署在生产环境,无法满足线上的性能要求。

当使用,以下命令启动Flask应用时:

1 | app.run(host = '0.0.0.0',port=6000) |

Flask框架会有一段

WARNING: This is a development server. Do not use it in a production deployment. Use a production WSGI server instead.

Gunicorn是基于unix系统,被广泛应用的高性能的Python WSGI HTTP Server。用来解析HTTP请求的网关服务。它通常是在进行反向代理(如nginx),或者进行负载均衡(如AWS ELB)和一个web 应用(比如Django或者Flask)之间。

目前,

gunicorn只能运行在Linux环境中,不支持windows平台。

后台程序挂起。在使用Flask、FastAPI或Gradio启动某些服务或API时,往往会将当前会话变成服务监控状态,如果会话关闭会导致服务也随之关闭。

有的人可能会说,可以使用

nohup将服务在后台执行,单是这样会生成额外的nohup.out文件,并且无法实时观看服务运行状态。

多个窗口之间来回切换。在Linux操作系统的使用过程中,可能会出现开启多个窗口的情况,随着窗口的逐步开启,自己都会忘记每个窗口有什么用,能不能关闭,管理起来非常麻烦。

终端工作环境可以实时保留,并且不会因会话关闭导致工作环境丢失。并且在不同设备上可以共享工作环境,不在拘泥于设备。

如果你也有以上烦恼,那么不妨试试Tmux这款工具。